画像生成AIの「Stable Diffusion」をコマンド操作不要で使えるソフト「NMKD Stable Diffusion GUI」で利用可能な便利機能をまとめました。

有志が作成した色々なオリジナルモデル(アニメイラスト特化、特定キャラ特化、人物特化…)を画像生成に使ったり、プロンプト中の語句に数値で重み付けできたり…

色々な機能や活用法がたくさんあるのでそれらを説明しています。

※基本的な使い方や機能・各設定項目はこちらに記載しています。まだご覧になっていない方は先にこちらをご確認ください。

入力したテキストから画像を生成したり、自分が描いた落書きに説明テキストを加えれば思い通りの絵に変えたりできるAI「Stable Diffusion」 ↑a sleeping cat in the hot spring (温泉で眠る[…]

追記(2023/4/30):別モデルファイルの利用に関して情報を追記しました。古くなった情報も併せて更新。

重み付きプロンプト

※追記:強調にもっと便利な構文

現在は重み付きプロンプトよりも簡単にプロンプト文の各要素の強調度を指定できる構文があります。

要素の強調が目的であれば以下のページに記載した機能を代わりに使用してください。

画像生成AIの「Stable Diffusion」をコマンド操作不要で簡単に使えるソフト「NMKD Stable Diffusion GUI」 のバージョン1.7台の新機能・変更点です。 含まれるバージョン 1.7.0 / 1.7.1 […]

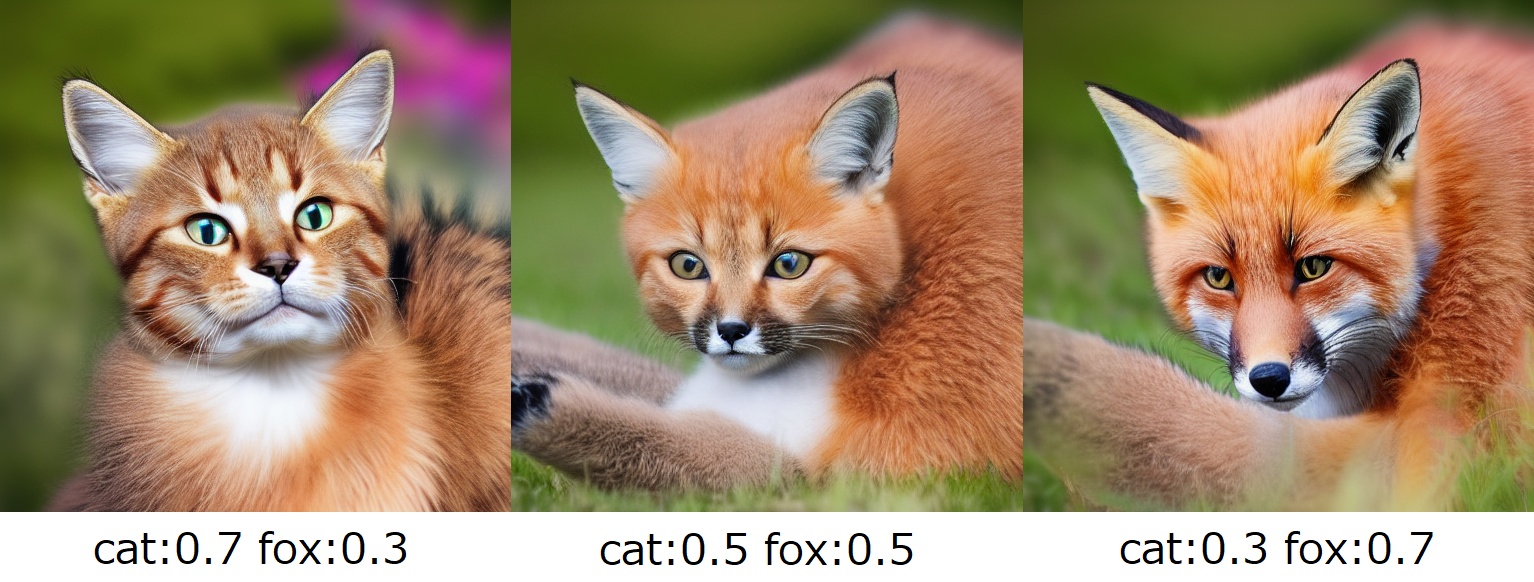

重み付きプロンプトは要素の強調ではなく、2つ以上の要素のミックス(融合)に使うのが最適です。

説明

プロンプト中の語句に数値を指定することで、その語句がプロンプトに中でどれほど重要か指示することができます。(重み付け)

これにより、2つの語句(要素)を任意の割合でミックスできるようになります。

これら3枚の画像はそれぞれ以下のプロンプト(呪文)で生成されています。

cat:0.5 fox:0.5

cat:0.3 fox:0.7

このようにプロンプト中の語句に半角コロン「:」と数値を付けることで、語句に重要度(重み)を付けることができます。

cat 7割 の状態は「きつね色のもふもふにゃんこ」な感じですが、fox の割合を増やしていくことでだんだんキツネさんに近づいています!

重み付けの仕様

many strawberries:0.6 green apples:0.4 on a plate

のように複数単語を含む語句に重み付けすることも一応可能ですが、要素を追加しすぎるとまともにプロンプト通りの画像が生成されなくなります。

重み付けしない言葉と同居させることも可能であり、また3語以上に重み付けすることもできます。

数値の合計が 1 になるように調整しなくても大丈夫なようです。

マイナスの重みで指定要素を排除 (※非推奨な使い方)

重みにはマイナスの値も指定可能で、その場合はマイナス値を指定した言葉が含まれないような画像が生成されます。

4枚は同一シード・設定で生成させましたが、cloudsにマイナスの重みをつけると雲量が確かに減っています。

ただ注意点として、負の値を大きくしていくとだんだん画像中の要素が変な色・形になりまともな画像が生成しなくなっていきます。

上記画像も clouds:-0.4 では雲が消えきる前に色調や形状がおかしくなり始めています。

-0.3辺りを超えるとおかしくなり始める印象なので、それを超えないくらいの軽めの値から調節を始めるのが良いと思います。

マイナスの重みの代わりに使える機能

マイナスの重みは使い勝手が悪いので、新しいソフトのバージョンでは代わりに以下の機能が使えます。

- 指定した語句が画像生成時に除外される「ネガティブプロンプト」

- 指定した語句が控えめに出力される「プロンプト強調構文」

生成画像からプロンプトや設定値を読み取り

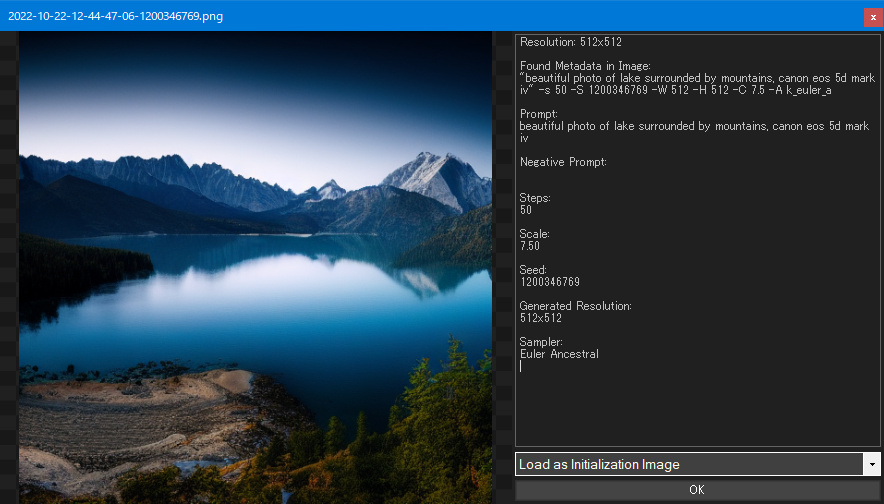

NMKD Stable Diffusion GUI で生成した画像には生成時に使用したプロンプトや各種設定値がデータとして埋め込まれているので、後からそれを読み取ることができます。

方法

まず、生成した画像をソフトにドラッグ&ドロップしてください。

すると次のような画像読み込み画面が表示されます。

今読み込んだ画像の設定データが右側のパネルに表示されています。

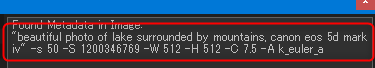

ちなみにパネル上部に表示されているデータ文字列(赤線部)の意味は次のとおりです。

"プロンプト文章" -s (ステップ数) -S (Seed値) -W (幅) -H (高さ) -C (CFG Scale値) -A (使用Sampler)

後から画像生成時のプロンプトや設定を調べられるので非常に便利です。

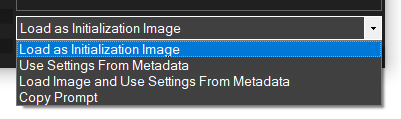

メニュー項目について

OK ボタンの上にあるメニュー項目から、読み込んだ画像を img2img 用に使うか読み取ったプロンプトや設定値をソフトに反映するか選べます。

| Load as Initialization Image | img2img 用の初期画像として読み込む |

| Use Settings From Metadata | 画像のメタデータから設定値を読み込み反映する (プロンプトやSeed値も含めた各設定値が読み込まれる) |

| Load Image and Use Settings From Metadata | 画像を img2img 用に読み込み、設定値も読み込む |

| Copy Prompt | 画像のプロンプトをクリップボードにコピーする |

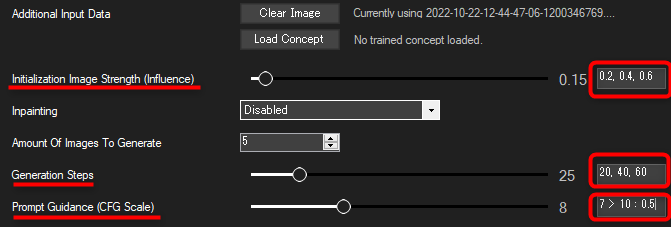

設定値を複数指定して画像を複数枚自動生成

Generation Steps, Prompt Guidance (CFG Scale) と img2img の Initialization Image Strength (Influence) は設定値を複数指定して画像を一括で生成させることができます。

赤枠で囲った設定値ボックスに入力します。

(画像では説明のため全部のボックスに入力していますが、必要なボックスだけに入力すればOKです)

値の複数指定

例えば Initialization Image Strength のところのボックスに「0.2, 0.4, 0.6」と指定すると、 1回の実行で Initialization Image Strength の設定が 0.2、0.4、0.6 の画像を生成してくれます。

複数の設定値で生成される画像を比べたいときにとても便利です。

(Initialization Image Strength の例で説明しましたが、他の設定値のボックスでも同様に指定可能です)

値の段階的増加指定

例えば Prompt Guidance に「7 > 10 : 0.5」と指定すると、「7から10まで、0.5刻みで」値を設定して画像を生成します。(7, 7.5, 8, 8.5, 9, 9.5, 10)

という指定書式です。

別のモデルの読み込み (.ckpt / .safetensors)

Stable Diffusion本家のモデルとは異なるモデルも有志により作成され配布されているので、それらを代わりに読み込んで画像生成に利用できます。

自分の作りたい画像に合わせてモデルを変更すると、生成する画像の質が著しく向上します。

(個人的に待望していた動物キャラ特化モデルも、現在は色々出ています!ฅ/ᐠ˶>ω<˶ᐟ\ฅ 嬉しい😸)

モデルファイルの入手

モデルファイルの形式について (.ckpt / .safetensors)

.ckpt 形式と .safetensors 形式がありますが、.safetensors 形式のモデルファイルはソフトで実行可能な .ckpt 形式に一度変換する必要があります。

変換方法は以下リンク先のページに記載したのでそちらをご確認ください。

最近、画像生成AI「Stable Diffusion」で利用するモデルファイルが .safetensors 形式で配布される機会が増えてきました。 NMKD Stable Diffusion GUI でその形式のモデルファイルを使うに[…]

.ckpt形式のモデルファイルなら変換不要でそのまま利用できます。

配布モデル一覧

現在は物凄いペースで配布モデルが増加しており全く追いきれていません…。

「Stable Diffusion モデル 一覧」で検索するのが早いと思います。(青字リンクから検索結果に飛べます)

Hugging Face や CivitAI といったモデル配布サイトもあります。(※Hugging Face は機械学習系コミュニティサイト)

※去年までよく使われていたモデルは以下のページにダウンロード先がまとめられています。

Rentry - Markdown Paste Service…

ピックアップ

(※一部、情報が古くてすみません)

二次元イラストで再訓練されたモデル。人間キャラクター向け。

※良くない絵 (age≧2×3²) も生成されてしまう可能性があるので注意。

ダウンロード(v1-3):wd-v1-3-float16.ckpt

※2023/03/29追記:現在は Stable Diffusion 2.1 をベースにした Waifu Diffusion 1.5 が最新のようですが、NMKD Stable Diffusion GUI では未対応だと思います。

(NMKD版ソフトでは、Stable Diffusion バージョン2台のモデルに未対応。次期対応予定らしいです)

AIに美少女描かせようとして「AIは日本の”萌え”をわかってない!」と挫折した人は多そうですが、waifu diffusionが物凄く作りやすくしてくれたので、今日から日本のAI使いが増えそうです。

シード厳選無しの"cute cat ears maid loli"だけでこれは世界変わりすぎ。 #stablediffusion #waifudiffusion pic.twitter.com/yWHdk4Xe1O— 白月めぐり (@alice_diffusion) September 8, 2022

Waifu Diffusion の詳しい情報共有場所はこちら。→ reddit リンク

trinart_stable_diffusion・trinart_stable_diffusion_v2

アニメ・マンガ絵用に再訓練されたモデル。

ダウンロード (v2):trinart2_step115000.ckpt

ダウンロード:trinart_stable_diffusion_epoch3.ckpt

昨日?Stable Diffusionのチェックポイントが公開されたので、早速ソースコードをいじってマンガ絵用に再訓練してみましたッ

すごい!きれい!早い! でも本格的な再訓練は1ヶ月はかかりそう……。 pic.twitter.com/DDHeoE1Tpr— Sta @ Bit192 / Tone Sphere 🍅 (@naclbbr) August 24, 2022

短いプロンプトで比較的高品質なイラスト画像を出力できると評判のモデル。

バージョン4.5は3.0の上位互換ではなく別系統のため、好みに合った物を選択するのが良い。

ダウンロード先と詳しい使い方はこちらのページに記載。

画像生成AI「Stable Diffusion」で使用できる画像生成モデルの一つ「Anything」をソフト NMKD Stable Diffusion GUI で使用する方法を記載しました。 Anything は短いプロンプトで比較[…]

↓以下はどちらも Anything V4.5 で生成された動物キャラさん。動物キャラOKなモデル。

※良くない絵 (age≧2×3²) も生成されてしまうので要注意。

Furry Diffusion v1.9 (unofficial)

動物キャラクター (furry・ケモノ)のイラストで再訓練されたAnythingベースのモデル。

(でも実は動物キャラ専門モデルを使わなくても、普通に Anything V4.5 を使えば動物キャラがちゃんと出てきました…!)

※良くない絵 (age≧2×3²) も生成されてしまうので注意。

ダウンロード:fd-v1.9.ckpt

動物キャラクター (furry・ケモノ)のイラストで再訓練されたモデル。(2022年までは主流だった)

※良くない絵 (age≧2×3²) も生成されてしまう可能性があるので注意。

ダウンロード (9/28時点):furry_epoch4.ckpt

情報源はこちら。

Stable Diffusionで動物キャラクターを作っている方にお知らせ

ついに動物キャラ(furry・ケモノ)に特化したモデルが作成されました!🐱🐶🦊

従来のSDやWaifuDiffusionではほぼ無理でしたが、furry_epoch4.ckpt ならこの系統の絵が出るようになります😺

(あとひと工夫でゆるかわ系のキャラも作れるかも!) pic.twitter.com/mF7GwtReBF— パジョカ (Pajoca)⁰😺Nya!😸 (@Pajoca_) September 27, 2022

本家 Stable Diffusion モデルの最新版。(2022/10/30時点)

※現在は Stable Diffusion 2.0 が出ていますが、NMKD Stable Diffusion GUI は未対応です。

ソフト同梱の Stable Diffusion は 1.5 に更新されました。そのため自前で導入する必要は無くなりました。

※現在は不要ですが、以下のページは参考用に残しておきます。

画像生成AIの Stable Diffusion の新バージョン 1.5 のモデルファイルが2022年10月20日に公開されました。 今回公開された新しい Stable Diffusion 1.5 をソフト NMKD Stable D[…]

別モデルの読み込み方法

ソフトにモデル切り替え機能があるので簡単に画像生成モデルを変更できます。

画像生成モデルファイル (.ckpt) の追加

- 画面右上の歯車ボタンを押して Settings(設定)画面を開く

- 設定項目「Stable Diffusion Model File」のところにある Folders... ボタンを押し、Model Folders 画面に移動する

- リストの「Data/models」をクリックして選び、右上にあるフォルダアイコンのボタンを押す

- 開かれたフォルダ画面に追加したいモデルの .ckpt ファイルを入れる

- Model Folders 画面を閉じる

使用モデルファイルの切り替え

一度追加したモデルファイルは非常に簡単に切り替えられます。

設定画面からも切替可能ですが、以下のショートカットを使ったほうが速いのでおすすめです。

- Ctrl + M キーのショートカットキーを押す

- 矢印キーで使用モデルを選択して Enter キーで決定

動物キャラ特化モデル試してみた

かわいい動物キャラがついに作れるように…!! やったー!!/ᐠ˶>ω<˶ᐟ\

アニメキャラ風の動物キャラクター(ケモノ)やイケメン獣人さんを生成するためのプロンプトはこちら↓

画像生成AIの「Stable Diffusion」に動物キャラクターのイラストを生成してもらう試みその②です。 人間キャラクターの作例はとても多いのに、動物キャラになった途端に情報皆無になってしまっているのでこちらでプロンプトなどを共[…]

動物キャラクターやいわゆるケモノ絵を生成するためのプロンプトや作成のコツをまとめました! (こちらは以前のモデル)

画像生成AIの「Stable Diffusion」で人間キャラクターを作成した例はたくさん見かけますが、動物キャラクターは情報が非常に少ないのでこちらに方法をまとめました。 かわいい動物キャラクター・マスコット・ケモノキャラを生成させ[…]

Waifu Diffusion 試してみた

(ねこちゃんがアニメキャラ風に😹 Waifu Diffusion では動物キャラは難しいです。素の Stable Diffusion よりは良くなるけど)

偶然出てきたいけめそねこくん!!😻

ファインチューニングで生成したモデルの読み込み

※現在は Dreambooth や LoRA(本ソフトでは未対応) が主流です。

Textual Inversion の .ptファイル / .binファイルをソフトで読み込んで利用する方法です

Textual Inversion により Stable Diffusion をファインチューニングすれば、例えば絵のキャラクターや画風を追加で学習させてそれを基に Stable Diffusion で画像生成を行うことができます。

(利用イメージはこちらを参照)

※ただしこの Textual Inversion 自体は NMKD Stable Diffusion GUI で実行できません。代わりに現在はより高性能なオリジナルモデル作成機能「Dreambooth」がソフトで実行できます。

.pt / .bin ファイルの読み込みと画像生成

Textual Inversion で作成した訓練ファイル (拡張子 .pt / .bin) を読み込むには、ソフト画面の「Load Concept」ボタンを押してください。

ファイル選択画面で訓練で生成させた .pt / .bin ファイルを開きます。

例えば好きなキャラクターで訓練して生成させた.pt / .binファイルを読み込ませたとして、そのキャラクターが立っている絵を生成させたかったら

というプロンプトを入力します。

アスタリスク「*」が読み込ませた訓練ファイルが表すもの(今回はキャラクター) を指すので、プロンプト中の好きな部分で言葉の代わりに「*」を使用してください。

あとは通常通り画像を生成させればOKです。img2img でも使えます。

詳しい使い方と利用イメージ

色々な人が作ったファインチューニングファイルがまとめて公開されている場所があるので、そこからモデルをダウンロードして NMKD Stable Diffusion GUI で使う方法について以下のページに記載しました。

「他の人がファインチューニングで生成した独自モデルを読み込む (.pt/.bin ファイル)」の項をご覧ください。

画像生成AIの「Stable Diffusion」をコマンド操作不要で簡単に使えるソフト「NMKD Stable Diffusion GUI」が 2022/09/20 に大型アップデートしました! 現在の最新版がバージョン 1.4.0[…]

みんなが作った .pt ファイル

自分で Textual Inversion が実行できる環境でなくても、他の人が作った .pt ファイルを読み込んで画像生成を楽しむことができます。

上記リンク先で説明した .bin ファイル以外にも、個人で自前で Textual Inversion を実行して .pt ファイルを作成している方もいるので以下にまとめます。

飼い猫の Buzz くんでファインチューニング

リンク:画像例 / 本人のコメントや作成時の設定・工夫など(reddit)

.ptファイルのダウンロード先:https://github.com/simcop2387/textual_inversion_sd/raw/master/embeddings_gs-14499.pt

↑Textual Inversion はなかなか訓練が難しいのですが、こちらの方はねこさんを結構綺麗に学習させることができています。

Stable Diffusion CLI でコマンド操作

コンソールの起動

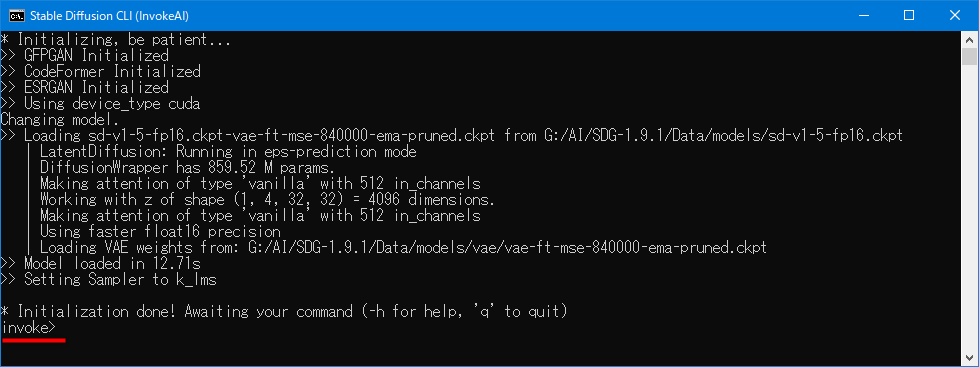

NMKD Stable Diffusion GUI から、コマンド操作ができるコンソールを起動可能です。

画像生成の各機能をコマンド操作で実行できます。

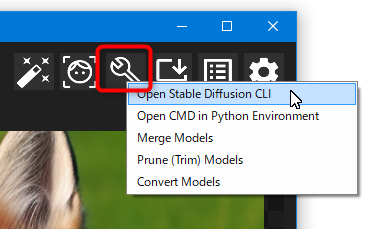

画面右上のレンチアイコンのボタンを押して「Open Stable Diffusion CLI」を選びます。

と表示されたら準備完了です。

「invoke>」の横にコマンドを入力します。

コマンドについて

コマンドの一覧や使い方はこちらに記載されています。

リンク:InvokeAI Stable Diffusion Toolkit Docs

実は NMKD Stable Diffusion GUI は、この InvokeAI Stable Diffusion Toolkit によるコマンド操作をGUIで行えるようにしたツールです。(つまり中身はこれ)

ソフトへの機能追加も、InvokeAI Stable Diffusion Toolkit の開発進行に合わせて行われている形です。

コマンドの使い方は上記リンク先ドキュメントの他、「-h」と入力してヘルプを表示させることでも確認できます。

コンソールのみで実行できる機能

※たくさんありそうですが調べられていません。公式ドキュメントをご参照ください。

★ テキストファイルからのプロンプト&設定の読み取りと実行

テキストファイルに1行ごとプロンプト・各設定を記載してそのテキストファイルを読み込ませることで、複数のプロンプトと設定を順次読み込んで画像を自動生成できます。

コンソールで実行できる機能の中では一番強力かも。

詳しい使い方はこちらをご参照ください。

img2img を 指定回数反復適用するための -v オプションがある

使い方:リンク

その他注意

使えるのは InvokeAI Stable Diffusion Toolkit で用意されたコマンドのみで、この画面から conda環境に移動してあれこれやることはできません。

(多分、それができるのはツールボタンから起動できる「Open CMD in Python Environment」)

それ以外の便利機能

このページで説明していない便利機能は、以下の各バージョン別ページに記載しています。(画像クリックで該当ページに移動できます)